hadoop

问题:

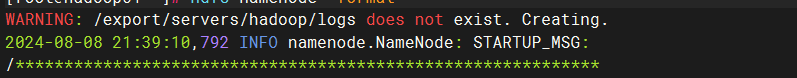

当在格式化的时候,第一条报错:

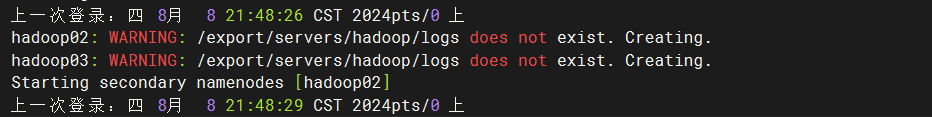

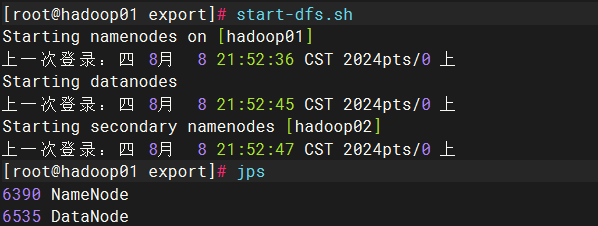

由此引发问题,在开启节点dfs.sh的时候:

解决方法:

进入你安装的hadoop目录,如我的是/export/servers,所以我需要进入/export

输入:

hdfs --daemon start journalnode再次开启节点,不会报错了

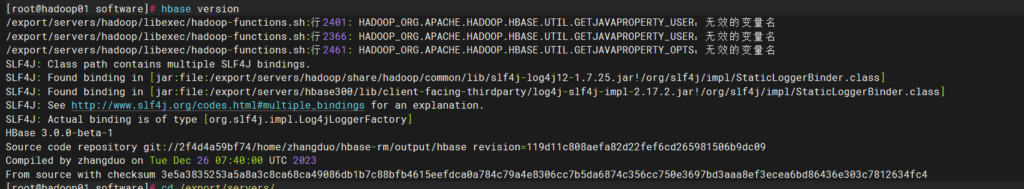

hbase

问题

出现该问题,找不到变量名,两个包的组件出现了问题

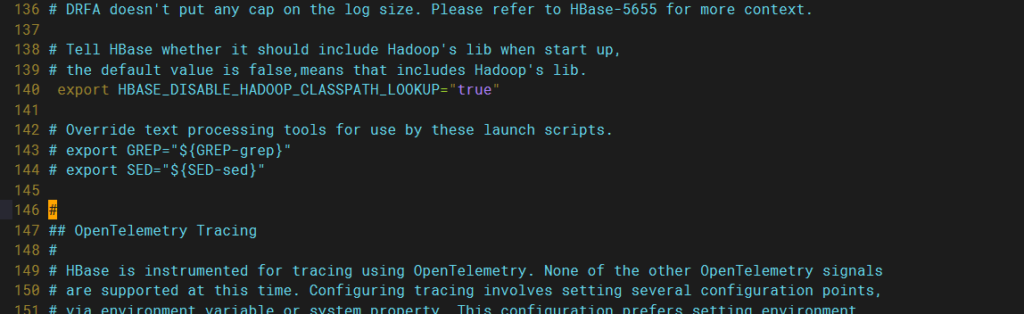

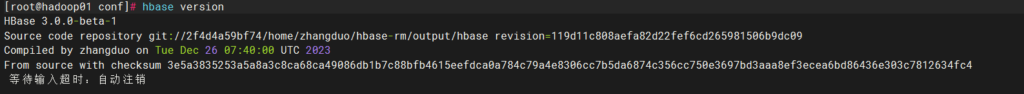

解决

打开配置文件

vim hbase-env.sh

去掉‘#’

解决

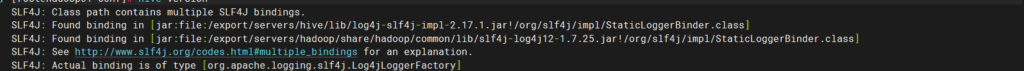

hive

问题

hadoop和hive包的slf4j产生了冲突,当多个不同的 SLF4J 绑定同时存在于类路径中时,SLF4J 不知道应该使用哪个具体的日志实现。

解决

两种方法

1.删掉低版本的一个,cp高版本的一个到低版本的路径

2.更改低版本一个包的名称

演示第二种

根据我的路径,我将log4j-slf4j-impl-2.17.1.jar 更名为log4j-slf4j-impl-2.17.1.bak

mv /export/servers/hive/lib/log4j-slf4j-impl-2.17.1.jar /export/servers/hive/lib/log4j-slf4j-impl-2.17.1.bak

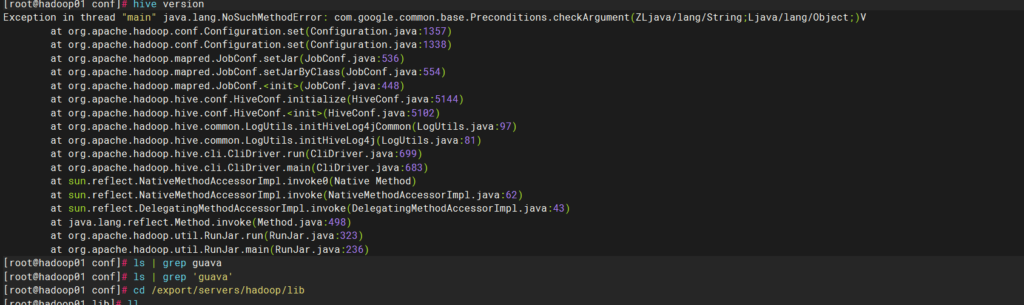

问题

第二种问题,即上图报错

Exception in thread “main” java.lang.NoSuchMethodError: com.google.common.base.Preconditions.checkArgument(ZLjava/lang/String;Ljava/lang/Object;)V

这种问题的思路:

- 系统找不到相关jar包

- 同一类型的 jar 包有不同版本存在,系统无法决定使用哪一个

解决

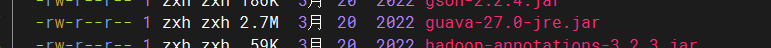

根据我们的查找,发现属于第二种情况,hadoop和hive存在不同版本的两个包,所以这里删除低版本的包,保留高版本的,然后将高版本包传给低版本

根据你的实际情况来定

在hadoop路径位于:

/export/servers/hadoop/share/hadoop/common/lib

在hive路径位于:

/export/servers/hive/lib

所以这里我删除下面这个,然后复制上面的到下面

[root@hadoop01 lib]# rm -rf guava-19.0.jar

[root@hadoop01 lib]# cp /export/servers/hadoop/share/hadoop/common/lib/guava-27.0-jre.jar /export/servers/hive/lib/

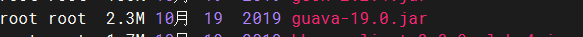

下图即成功

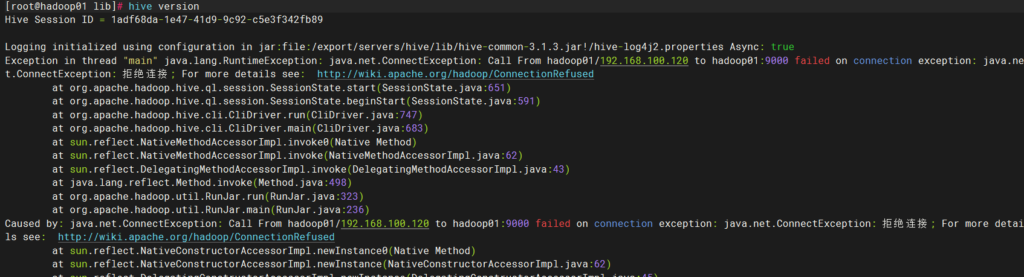

问题

下图的问题是因为hhadoop没有启动,解决问题不说了

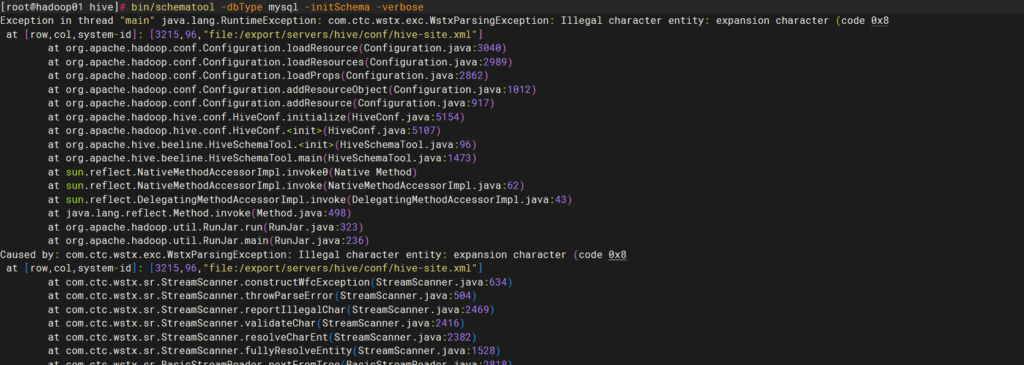

问题

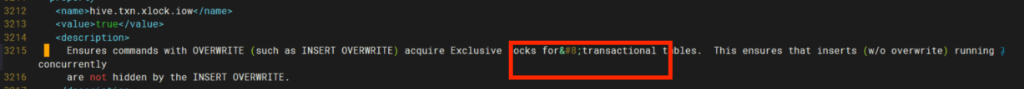

在元数据库初始化的时候,报错字符集错误

解决

根据报错提示,找到3215行,删除错误字符集即可

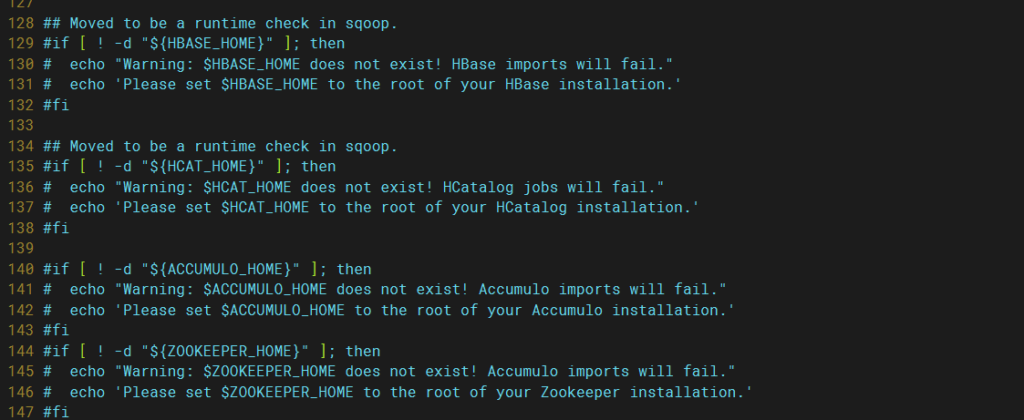

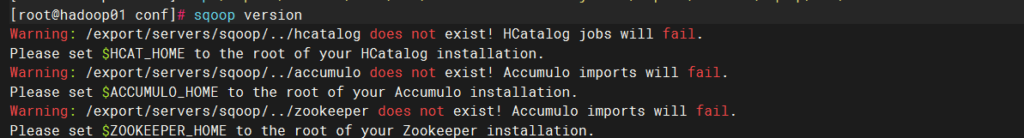

sqoop

问题

报错以下提示

解决

以下路径

[root@hadoop01 sqoop]# cd bin/

[root@hadoop01 bin]# pwd

/export/servers/sqoop/bin

[root@hadoop01 bin]# vim configure-sqoop在以下全部数据前 加上‘#’